Edwin Vogt (Jahrgang 1932) war von 1961

bis 1996 im Entwicklungsbereich der IBM Deutschland tätig. Nach einem

Algol-Projekt 1962-1963 im französischen Labor in La Gaude folgte eine

Abordnung in die USA. Von 1967 bis 1984 war er Leiter der Systementwicklung des

Böblinger Labors und verantwortete die Entwicklung mehrerer IBM

Rechnerfamilien. Zu erwähnen sind das System/360 Modell 125 sowie die Systeme

IBM 4331, 4361 und 9377. Über mehrere Jahre hinweg schloss seine Verantwortung

auch die maschinen-nahe Software-Entwicklung mit ein, d.h. das Betriebssystem

DOS/VSE. Im Jahre 1987 übernahm er die Leitung des

Programm-Entwicklungszentrums (PPDC) Sindelfingen. Daraus entstand ein eigenes

Anwendungsentwicklungslabor mit weltweiter Produktverantwortung im Datenbank-

und Data-Warehouse-Bereich.

Nach seiner Pensionierung im Jahre 1996

wurde Vogt zum Geschäftsführenden Vorstand einer Startup-Förderinitiative

ernannt. Das Softwarezentrum Böblingen/Sindelfingen e.V. ist eine vom Land Baden-Württemberg,

der örtlichen Bezirkskammer der IHK und den Städten Böblingen und Sindelfingen

Ende 1995 initiierte Organisation. Vogt leitete sie bis August 1999. Danach

wurde er Vizepräsident Forschung & Entwicklung für Xybernaut, einer Firma,

die Rechner baute, die bei Montage-Arbeiten am Körper des Monteurs getragen

werden. Seit April 2011 ist er Leiter der Basketballabteilung der Böblingen

Panthers. Vogt ist promovierter Elektrotechniker der Universität Stuttgart.

Familie Vogt hat drei erwachsene Söhne, acht Enkel und einen Urenkel.

Bertal

Dresen (BD): Wir kennen uns seit unserer gemeinsamen Zeit vor über 50 Jahren im

französischen Labor der IBM. Das war bei einem Software-Projekt in La Gaude an

der Côte d’Azur unweit von Nizza. Wir lassen diese Wanderjahre einmal außen vor

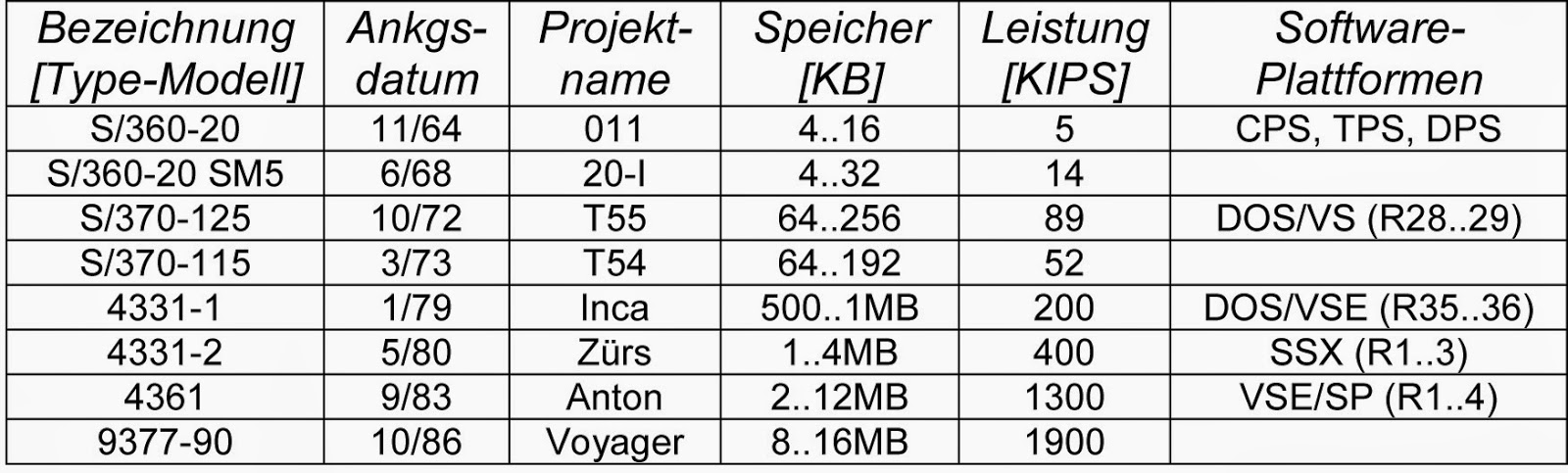

und beginnen mit der Prozessoren-Entwicklung in Böblingen. Damit Sie einen

Bezugspunkt haben, stelle ich einen Auszug aus einer Tabelle vorne weg, die

sich (ohne die Software-Spalte) in Helmut Painkes Buch [1] (Seite 167)

befindet. Sie können dann frei zwischen Produktbezeichnung und internem

Projektnamen wechseln. Was war der erste technische Höhepunkt, an den Sie

sich erinnern?

Edwin

Vogt (EV): Meine Zeit als Leiter der Prozessoren-Entwicklung, intern meist Systementwicklung

genannt, begann 1967 mit der Entwicklung des System/360 Model 20 Submodel 5

(Codename 20-I). Diese war das erste ausgelieferte System, in dem der Kontrollspeicher

für die Mikroprogrammierung in den Datenspeicher integriert war. Ein prototypischer

Vorläufer (Codename M10) unter meinem Vorgänger Wilhelm

Spruth hatte diese Technologie erstmals angewandt. Dies erlaubte auch die

Mikroprogrammierung durch Entwicklungsverfahren zu unterstützen, die in der Software

Stand der Technik waren.

Wir haben damals einen Interpreter für die kommerzielle Programmiersprache

RPG (Report Program Generator) direkt im Mikroprogramm (unter dem Codenamen

GOML) implementiert. Die 20-I lief dann als RPG-Maschine fantastisch. Die IBM

hat aber die Auslieferung gestoppt, weil die 20-I in diesem Modus schneller war

als die größeren Modelle 30 und 40 des Systems/360 und gleichzeitig das kleine

kommerzielle Systeme/3 der späteren General Sytems Division (GSD) überflüssig gemacht hätte.

BD: Sie heben sofort

die interne Konkurrenz hervor. Fast kann man meinen, dass diese wichtiger war

als die externe Konkurrenz. Dieser Vorwurf wurde uns IBMern damals häufig

gemacht. Halten Sie ihn für berechtigt?

EV: Dieser Vorwurf ist berechtigt.

Die IBM war in „Divisions“ aufgeteilt, die bestimmte Hardwareproduktbereiche

und als Anhängsel ein dazugehörendes Betriebssystem abdeckten. Wir gehörten zur

Data Systems Division (DSD) und beackerten hier das untere Ende dieses

Bereichs. Poughkeepsie hatte das obere Ende und Endicott den mittleren Bereich.

Diese beiden viel größeren Labors, die auch das Division Management stellten,

hatten kein Interesse sich mit anderen Systemlabors (wie Rochester oder San

Jose) anzulegen. Bob Evans [damals Vizepräsident

und Entwicklungschef der DSD] versuchte dies, war aber nicht erfolgreich, da

das Corporate Management angesichts der Profitabilität der IBM und ihrer Marktmacht

im Computerbereich, diese Produktproliferation als nicht kritisch ansah. Es gab

sogar Personen, speziell im Marketing- und Forschungsbereich, die ̶ etwas arrogant und kurzsichtig ̶ diese

sogar positiv unterstützten nach dem Motto „Wenn wir schon keine externe Konkurrenz

haben, machen wir dies intern“.

BD: Zurück ins Böblinger Labor. Was beschäftigte

Sie als nächstes?

EV: Die Modelle 125 und

115 des Systems/370 waren die ersten Computersysteme, in denen die System/370-Architektur

durch ein mikroprogrammiertes Multiprozessorensystem, mit eigenem Speicher per

Prozessoreinheit, realisiert wurden. Dabei wurden die Mikroprogramme in

Verbindung mit einem Serviceprozessor über eines der ersten zur Verfügung

stehenden Diskettensysteme (IGAR) in die einzelnen parallel laufenden

Prozessoren geladen und so das Gesamtsystem initialisiert (engl. bootstrapping).

Die einzelnen Prozessoren waren auf ihre Aufgaben zugeschnitten, so der Serviceprozessor

(SVP), die I/O-Prozessoren und die Instruction

Processing Unit (IPU). Ihr Zusammenspiel wurde über den SVP koordiniert. Das

war eine technologische Entwicklung, die weit über damals implementierten CPU-Strukturen

hinausging.

BD: Zwischen dem

Modell 115 und der IBM 4331 liegen fast sechs Jahre. Das war die berühmt-berüchtigte

FS-Zeit. Die Ziele der FS-Architektur hatte ich in einem Nachruf auf George Radin in diesem Blog erklärt.

Was verbinden Sie mit FS? Waren es wirklich völlig verlorene Jahre aus

Böblinger Sicht?

EV: Das FS-Projekt

trieb die Computer-Technologien voran in Bezug auf Architektur und

Programmierung. Für die Prozessoren-Entwicklung selbst aber waren es verlorene

Jahre, welche die IBM nur auf Grund ihrer Markmacht überlebte. Die 4331-1 war

meiner Ansicht nach das größte Geheimprojekt (engl. bootlegging) in der

IBM-Geschichte und nur so gelang es nach mehr als vier verlorenen Jahren ein

System innerhalb kürzester Zeit (18 Monate) auf den Markt zu bringen. Dieses

System war voll S/370-kompatibel.

BD: Mit der IBM 4331

verbinde ich zwei technische Problemstellungen, mit denen wir beide gemeinsam

zu kämpfen hatten, die spezielle Rechnerarchitektur für die kleinen Systeme der

System/370-Familie, E-Mode genannt,

und die Plattenarchitektur, als Fixed

Block Architecture (FBA) bekannt. Der E-Mode bot einen einzelnen in Mikrocode

realisierten virtuellen Adressraum von 16 MB an. Durch FBA wurden Magnetplatten

mit fester Blocklänge (damals 512 Bytes) beschrieben. In beiden Fällen ging es

darum, Hardware-Kosten zu sparen, teilweise zu Lasten einer speziellen Software-Entwicklung.

Ich sehe dies als Tradeoff, der nur in einer spezifischen Phase unserer

Technologie zu rechtfertigen war. Sehen Sie dies auch so? War die Koppelung der

Böblinger Hardware nur an das Betriebssystem DOS/VS nicht zu einschränkend, wo doch bereits viele

Nutzer mit Hilfe von VM/370 alternative Software-Umgebungen betrieben?

EV: Ich sehe die

angeführten Punkte nicht ganz so. Der E-Mode für die S/370-Systeme war am

Anfang durch die Hardware-Kosten getrieben. Die 4331 war aber schon voll S/370-kompatibel.

Das dadurch entstandene Betriebssystem DOS/VSE hätte sehr wohl als einziges

Eingangssystem der IBM dienen können. Dies wurde aber verpasst, weil die DOS/VSE-Entwickler

nicht erkannten, dass in diesem Bereich die Benützbarkeit wichtiger ist, als die

funktionelle Komplexität. Dadurch entstanden zur S/370 inkompatible Architekturen

und Betriebssysteme, die nicht notwendig gewesen wären. Die FBA-Architektur war

durch die Plattentechnologie getrieben. Sie hätte ohne weiteres später als Teil

einer Erweiterungsstrategie benützt werden können, was ja auch zum Teil

geschehen ist.

BD: An der obigen

Tabelle ist sehr schön zu sehen, wie die Leistungsfähigkeit Böblinger Systeme

wuchs. Schließlich gab es auf der Hardware-Seite keinen Unterschied mehr zu den

Großsystemen, was die Architektur der Systeme betraf. Was kennzeichnete diese

Systeme?

EV: Die IBM 4361 (intern

Anton genannt, nach dem Skiort St. Anton), als Weiter-entwicklung der 4331, war

der erste IBM-Rechner, bei dem die Bedienerkonsole ein Bildschirm war, der am

Serviceprozessor angeschlossen war. Sowohl das Betriebssystem als auch die

Mikroprogramme, inklusive der Hardware-Wartungsprogramme,

konnten von hier aus gesteuert werden. Für die IPU wurde ein Konzept für den S/370-Instruktionssatz

entwickelt, bei dem ein sogenannter RISC-Instruktionssatz direkt in Hardware

implementiert wurde. Nur die komplexeren Instruktionen wurden per Mikroprogramm

ausgeführt. (Weitere Details beschreibe ich bei der späteren Frage über RISC-Prozessoren).

Dass dieses Konzept in der IBM nicht erkannt und vorangetrieben wurde,

bezeichnete Jack

Kuehler [damals IBM Vizepräsident] später als seinen größten Fehler in

seinen technologischen Entscheidungen. Die 4361 war in ihrer Leistungsfähigkeit

(gemessen als Leistung pro Anzahl der Schaltkreise) allen IBM-Systemen in diesem

Zeitraum so überlegen, dass wir ̶ in einer speziellen durch die Corporation eingesetzten

Taskforce ̶ den Entwicklern aus Poughkeepsie,

Endicott und Rochester unseren Designs erklären mussten. Man hat das 4361-Konzept

als „best of breed“ anerkannt, aber in den anderen Labors wurden daraus keine

Lehren gezogen.

BD: Welche ehemaligen Kollegen

trugen den maßgeblichen Anteil an dem Erfolg der Systementwicklung? Mit welchen

andern Labors der Firma bestanden intensive Kontakte?

EV: Wichtig war für

mich ein Team zu haben, das ich an die durch den schnellen technologischen

Fortschritt gegebenen Möglichkeiten heranbringen konnte. Die Struktur des Teams

musste so aufgebaut sein, dass es Personen gab, die mich hierbei kritisch

begleiteten (z.B. Helmut Painke und Günter Knauft), aber auch Personen

beinhaltete die entweder die vorgegebene Richtung dann umsetzen konnten (z.B. Leo

Reichl und Horst von der Hayden) oder die auf Grund ihrer technischen Brillanz

einsame Spitze waren (z. B: Johann Hajdu und Hans-Hermann Lampe) und Personen

mit denen ich dies zu einer Gesamtlösung zusammenbringen konnte (z.B. Helmut

Weber und Karl-Heinz Strassemeyer). Diese Entwicklung war auch durch die engen

Kontakte mit der Technologieentwicklung des Labors (die Kollegen Folberth und Spielmann)

möglich. Es bestanden weiterhin enge Kontakte zu den Labors in Endicott und Poughkeepsie,

in Teilen zur Technologieentwicklung in East-Fishkill und zu Research Centers

in Yorktown Heights und Almaden.

BD: In der Frage,

welche Rolle die RISC-Architektur spielen sollte, waren Sie und George Radin geteilter

Meinung. Können Sie in wenigen Sätzen den damaligen Disput beschreiben?

EV: Wie bereits

gesagt, hatte die 4361-IPU einen RISC-Instruktionssatz der aus einer Untermenge

der S/370 Instruktionen vom Typ RR, RX und SI bestand. Dieser Instruktionssatz

war für den sogenannten „Commercial Instruction Mix“ nur 2-3% langsamer als der von Radin entwickelte, der

auch nach dem damaligen Data General Commercial Rating (DGCR) gemessen wurde. Er

war auch im Implementierungsaufwand (Schaltkreise/DGCR) absolut

konkurrenzfähig. Dies passte Radin und anderen Research-Gurus nicht. Deshalb

wurde nie der Versuch unternommen, auf diesem Instruktionssatz basierend, auf

der S/370/125 UNIX laufen zu lassen, darauf die DG-Software-Systeme zu

konvertieren oder diesen auf Effektivität mit den beim System/1800, dem System/36

und dem späteren System/38 und AS/400 benützten Architekturen zu vergleichen.

Wir wussten, dass wir im Durchsatz besser oder zumindest gleich gut wie diese

Systeme gewesen wären.

Die

IBM hätte in diesem Fall große Teile

ihrer Ressourcen in Research und in GSD nicht mehr gebraucht und hätte immense

Mengen an Geld sparen können und sich für Konkurrenzsoftware zu diesem

Zeitpunkt öffnen können. Dazu war die IBM Managementstruktur zu wenig flexibel,

technisch, in vielen Fällen, zu inkompetent und viel zu stark nach innen orientiert. Ich habe nur zwei Manager kennengelernt, die dies verstanden haben: Jack

Kuehler und Earl Wheeler [Wheeler stammte aus

der DOS-Entwicklung in Endicott und leitete später das gesamte

Software-Produkt-Geschäft der IBM]. Beide haben mir in Gesprächen nach ihrer Pensionierung

bestätigt, dass sie die Nichtverfolgung dieses Zieles als einen ihrer größten

Fehler sahen und sie die Durchsetzung dieses Konzepts auch unterlassen haben,

weil sie nicht gegen den Rest der IBM antreten wollten.

BD: Von Bob Evans [2] stammt

die Aussage, dass IBM auch im PC-Geschäft hätte erfolgreich sein können, wenn

man voll auf RISC-Mikroprozessoren gesetzt hätte, und zwar unter Beibehaltung

aller Software-Rechte. Was wäre, wenn…? Solche Diskussionen sind zwar meist

fruchtlos. Dennoch würde mich interessieren, welche Gründe Sie für IBMs

Rückgang im Hardware-Geschäft anführen würden. Welche Fehler wurden von unsern

ehemaligen Hardware-Kollegen gemacht? Welche Rolle spielten externe Einflüsse?

EV: Bob Evans hat

vollständig recht: Nur noch ein zusätzlicher Kommentar: IBM kam hier in

Schwierigkeiten, weil sie keine Struktur und zu wenige Manager hatten, die

gesehen hätten, dass das Vorantreiben der Technologien interne Strukturveränderungen

erfordert. IBM war zu einer Bürokratie degeneriert, in der die Bürokraten, als inkompetente

Produktplaner und Produktmanager getarnt, den Fortschritt verhinderten. Die Wenigen,

die dies hätten noch ändern können, hatten keine Chance sich durchzusetzen und haben

zum Teil dies auch nicht versucht. Tödlich für die IBM war hier das Fehlen

einer technisch kompetenten Person (wie z.B. Fred Brooks bei der S/360-Architektur),

der die Hardware und Software in ein umfassendes System forciert hätte. Jack

Kuehler [von der Plattenentwicklung kommend] hatte hier zu wenig Software-Hintergrund,

Bob Evans hatte zu diesem Zeitpunkt nicht mehr den Einfluss, um dies

weitertreiben und umsetzen zu können. Die Größe der IBM und ihre Inflexibilität

über Organisationsstrukturen hinweg machten sich hier bemerkbar.

BD: Während Ihrer Zeit

als Leiter des PPDC und auch nach Ihrer IBM-Zeit waren Sie vorwiegend im Software-Geschäft

tätig. Kann man daraus schließen, dass Sie der Software ein größeres Potenzial

beimessen als der Hardware, oder ist es nur der Ausdruck Ihrer Vielseitigkeit? Teilen

Sie die Meinung, die auch unser Ex-Kollege Karl-Heinz

Strassemeyer in diesen Blog vertrat, dass eine Firma, die nicht eine Gesamtsystemsicht

vertritt, also Hardware und Software als Einheit betrachtet, einen Fehler

macht? Hat IBM nicht zu lange und zu sehr das von Hardware unabhängige Software-Geschäft

unterschätzt? Rettete nicht der von Earl Wheeler aufgebaute und später von Steve Mills geleitete

Software-Bereich in den letzten Jahrzehnten die IBM vor dem Bankrott? Wie sehen

Sie heute die Beziehung von Hardware und Software und die Zukunft der IBM als

Teil der Software-Branche?

EV: Ich verließ 1987 die

Systementwicklung und das Böblinger Labor und übernahm in der IBM Deutschland

als Direktor die Planungs- und Softwareaktivitäten. Das schloss das Program

Product Development Center (PPDC) in Sindelfingen mit ein. Dieses nahm organisatorisch

eine Zwitterstellung ein, indem es Softwareprodukte entwickelte, aber nicht

wirklich in die Organisation der IBM Software-Produktentwicklung integriert

war. Meine Kontakte in die US-Entwicklungsorganisationen und das Corporate

Management halfen mir, diese Entwicklungsgruppe weiter auszubauen und den unkontrollierten

Wildwuchs von Softwareaktivitäten innerhalb der IBM Deutschland zu straffen.

Ich

betrachte aber diesen Wechsel in die IBM Deutschland als meinen größten Fehler

in meiner IBM-Laufbahn, da ich mich in einer aufgeblähten, rein durch Vertriebsanreize

getriebenen Marketingorganisation wiederfand. Nachdem man mir die Planungsaktivitäten

weggenommen hatte, wollte ich die IBM verlassen. Ich besprach dies mit Earl

Wheeler im Februar 1990 in Berlin und er bot mir einen Job an, der alle Softwareentwicklungsaktivitäten

seiner Organisation in Europa unter meiner Leitung konsolidierte. Dies betraf

die Labors in Dublin, Warwick, Wien und das PPDC, das auch weitgehend von ihm

finanziert und später als German Software Development Lab (GSDL) in diesen

Verbund integriert wurde. Im März 1990 informierte Earl Wheeler in einem kurzen

Schreiben den damaligen Geschäftsführer der IBM Deutschland (Hans Olaf Henkel) über

diese Organisationsänderung.

Bis

zu dem mit meiner Pensionierung verbundenen Ausscheiden aus der IBM Ende 1995

berichtete ich an Earl Wheeler und an seinen Nachfolger Steve Mills. Ich konzentrierte

die Aktivitäten der genannten Labors auf Datenbankaktivitäten, Dokumentenmanagement

und neu hinzukommend Workflowmanagement. Im Rahmen der Konsolidierungsmaßnahmen

unter Lou Gerstner mussten wir in den folgenden Jahren Dublin, Warwick und am

Schluss auch Wien schließen und diese Aktivitäten im GSDL konsolidieren. Im

Zeitraum von 1990 bis 1995 war übrigens das GSDL die einzige

Entwicklungsorganisation innerhalb der gesamten IBM, die wuchs. Besonders unter

Steve Mills wurde die Softwareorganisation stark ausgebaut und ohne diese

erfolgreiche Organisation hätte es die IBM nie geschafft, sich von einer fast ausschließlich

von Hardware getriebenen Organisation in ein durch Orientierung auf Software

und Service erfolgreiches Unternehmen umzuwandeln.

BD: Das Softwarezentrum

Böblingen-Sindelfingen (SBS) ist eine Gründung der beiden benachbarten Städte. Obwohl

deren Zusammenarbeit sonst oft schwerfällt, hier scheint sie zu klappen. Worauf

führen Sie den anhaltenden Erfolg des Zentrums zurück? Welches Profil haben

typische Firmengründer? Was ist ihr Geschäftsmodell? Woher kommen die Aufträge?

Welche Rolle spielen Hardware-Projekte? Gab es auch Probleme und Misserfolge?

EV: Als ich Ende 1995

mit 63 Jahren aus der IBM ausschied, wurde mir angeboten das SBS aufzubauen, das in

einem von der IBM aufgegebenen Laborgebäude für Bankenterminalentwicklung

untergebracht war. Diese Organisation sollte in Form eines Vereins, kleine neuzugründende

Softwareunternehmen unterstützen und ihnen eine Infrastruktur für deren

erfolgreichen Aufbau anbieten. Diese Vorhaben wurde vom Land Baden/Württemberg

(unter Erwin Teufel als Ministerpräsident und Dieter Spöri als

Wirtschaftsminister) über eine Anfangsfinanzierung unterstützt, wurde in der IHK

organisatorisch verankert und vorangetrieben, von Daimler-Benz, HP und IBM als

mögliche Projektlieferanten unterstützt. Es erhielt von den Städten Böblingen

und Sindelfingen positiven Beistand als Teil ihrer Industrieansiedlungspolitik.

Von

Anfang an wurde der Fokus ausschließlich auf die Software-getriebene Serviceentwicklung

gelegt und Firmen in den Verbund aufgenommen, die diese Aufgabe entweder direkt

oder indirekt wahrnahmen. Außerdem mussten sie willens sein mit anderen

Firmenpartnern im SBS-Verbund zu kooperieren. Hardware orientierte Entwicklungen

waren dabei nur als Träger für neue Softwaretechnologien interessant. Zusätzlich

wurde diesen Firmen in der Projektfindung von in der Region ansässigen Großfirmen

wie Daimler, HP und IBM aktiv unterstützt. Diese Auswahlkriterien und die damit

verbundene Firmenselektionen wurden rigoros durchgesetzt und Verwässerungen

durch Einflussnahme von außen (Kommunen, IHK und politische Gremien) minimiert.

Diese Vorgehenswiese war und ist der Schlüssel zum Erfolg des SBS.

Im

SBS waren bei meinem Ausscheiden 42 Firmen mit 220 Mitarbeitern angesiedelt.

Diese Zahlen wuchsen bis heute auf 110 Firmen mit 750 Mitarbeitern an. Dabei wuchsen

einige Firmen so stark, dass sie nur noch ihren Hauptsitz im SBS haben, wie Spirit/21

mit heute 500 Mitarbeitern, oder dass sie aus dem SBS in eigene Gebäude umzogen

wie die Compart AG mit heute 200 Mitarbeitern.

BD: Sie waren bzw.

sind auch selbst an einer der dort ansässigen Firmen beteiligt. Welche

ist das? Was tut sie? Welche Aufgaben haben Sie?

EV; Während meiner

Zeit als Leiter des SBS wurde ich von vielen Firmen angesprochen, die mich als Geschäftsführer

(CEO), Entwicklungsleiter oder Berater einstellen wollten. Das für mich

interessanteste Angebot kam von dem amerikanischen Unternehmen Xybernaut, die

in Fairfax, VA, beheimatet war und absoluter Technologie- und Marktführer auf

dem Segment des Mobile & Wearable Computing war. Da ich mit meiner Familie

nicht nach Amerika gehen wollte, verlegte diese Firma ihre vollständige

Entwicklung in eine deutsche Tochter, die im Softwarezentrum angesiedelt wurde

und ernannten mich zum Entwicklungschef als Senior Vice President der Xybernaut

Corp. Die Übernahme dieser für mich sehr interessanten Aufgabe erforderte, dass

ich im Jahr 1999 die Führung des SBS aufgab und mich nur noch dieser Aufgabe

widmete.

Dieses

Arbeitsgebiet war sehr interessant und auf mein Wissen und meine Erfahrung

zugeschnitten. Wir waren an der Vorderfront der technologischen Entwicklung und

den Marktgegebenheiten etwa fünf bis zehn Jahre voraus Die Firma Xybernaut hatte

nicht die Kapitalkraft um die Zeit, bis ein profitables Geschäft daraus möglich

war, zu überstehen. Als die Mutterfirma

2005 in Insolvenz ging, löste ich die deutsche Tochter aus dieser Firma heraus und

übernahm sie als persönlich haftender Eigentümer. Sie heißt teXXmo Mobile

Solution GmbH & Co KG. Die Firma arbeitet heute als profitables Unternehmen

mit einem guten Ruf auf dem mobilen industriellen Sektor in Europa und ist

immer noch im SBS angesiedelt.

BD: Wer Sie vor

40 Jahren in Ihrem Büro aufsuchte, dem konnte passieren, dass er ins Testlabor

geschickt wurde. Dort konnte man Sie dann im weißen Hemd und mit Krawatte

hinter einer Maschine liegend finden. Sie gaben gerade einem Techniker

Hinweise, der aufgelötete Schaltverbindungen überprüfte. Sind Sie immer noch der

Ingenieur, der auch im Alter gerne selber mit Hand anlegt?

EV: Ja, das mir macht

mir immer noch Spaß.

BD: Lange nach

Beendigung Ihrer aktiven Zeit als Basketballer leiten Sie eine örtliche Basketball-Abteilung.

Ist das ein Ausgleich für einen Manager oder ist es die gleiche Tätigkeit, nur

mit andern Leuten und anderen Zielen? Demgegenüber muss doch das Schnapsbrennen

aus den eigenen Mirabellen zu hervorragenden geistvollen Produkten zu führen. Oder

kann nur das Golfspielen sie wirklich entspannen?

EV: In die Leitung der

Basketballabteilung wurde ich von alten Basketballkollegen getrieben, da die

Gefahr bestand, dass die Abteilung auseinander bricht. Leider habe ich den

Eindruck, dass ich das zu gut mache und ich daher nicht wieder richtig aus der

Sache herauskomme. Beim Schnapsbrennen als meinem dritten „Standbein“ kommt

meine in erster Generation schwäbische Seele zum Vorschein: „Ja nichts

verderben lassen!“ ist das Motto. Beim Golfspielen entspanne ich tatsächlich

und meine Frau und ich haben gemeinsam viel Spaß dabei.

BD: Herr Vogt, ich

danke Ihnen sehr für das ausführliche Interview und wünsche Ihnen weiterhin Erfolg

bei all ihren Geschäften.

Zusätzliche Referenzen

- Painke, H.: Forschung und Entwicklung in der IBM Deutschland. 4. Die IBM Laboratorien Böblingen: System-Entwicklung. 2003

- Evans, B. O.: The Stumbling Titan. In: P. J. Denning, R. M. Metcalfe: Beyond Calculation. The Next Fifty Years of Computing. 1998